„Kiemelkedő” csaló iskolák

By knauszi on 2019. ápr. 19. - 20:03

Nahalka István írása

Az oktatáskutató szomorú, mert az amúgy rendkívül nagy értékkel rendelkező kompetenciamérési adatok „elszennyeződnek”, bizonytalanokká válnak, bizonytalanná téve ezzel a belőlük levonható következtetéseket is.

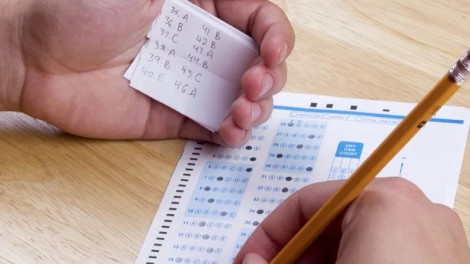

Egyszer el kell kezdeni nyilvánosan is beszélni erről. Nyílt titok a pedagógus szakmán belül, hogy vannak iskolák, amelyek csalnak az Országos kompetenciamérésben (OKM). Több módja is van, például meg kell kérni a gyengébb tanulókat, hogy az OKM-tesztelés napján maradjanak otthon, lehet megadni a tesztírás tantermében egyes gyerekeknek, vagy akár mindegyiknek a jó megoldásokat, finoman fel lehet hívni a figyelmet hibákra, üresen hagyott válaszok esetén utólag be lehet írni a megoldásokat, és így tovább. Közvetlenül és minden kétséget kizáróan soha nem tudjuk majd valószínűleg egyetlen esetben sem bebizonyítani, hogy ez történt, hacsak egy-egy intézményben tömegesen nem vállalják tanulók és pedagógusok, hogy nyíltan beszélni kezdenek a dologról.

Egyszer el kell kezdeni nyilvánosan is beszélni erről. Nyílt titok a pedagógus szakmán belül, hogy vannak iskolák, amelyek csalnak az Országos kompetenciamérésben (OKM). Több módja is van, például meg kell kérni a gyengébb tanulókat, hogy az OKM-tesztelés napján maradjanak otthon, lehet megadni a tesztírás tantermében egyes gyerekeknek, vagy akár mindegyiknek a jó megoldásokat, finoman fel lehet hívni a figyelmet hibákra, üresen hagyott válaszok esetén utólag be lehet írni a megoldásokat, és így tovább. Közvetlenül és minden kétséget kizáróan soha nem tudjuk majd valószínűleg egyetlen esetben sem bebizonyítani, hogy ez történt, hacsak egy-egy intézményben tömegesen nem vállalják tanulók és pedagógusok, hogy nyíltan beszélni kezdenek a dologról.

A jelenség mindenhol ismert, ahol téttel bíró teszteket íratnak a gyerekekkel. Itt és most nem részletezhető széles körű szakirodalma van a témának (csak ízelítőül: Cullen és Reback 2002; Jacob és Levitt 2002; Nichols és Berliner 2007). Az Egyesült Államokban, ahol a tesztelés tétje jelentősebb, mint nálunk, a különböző becslések 5% alattira teszik azon iskolák arányát, amelyekben előfordulnak csalások, a legtöbb kutatásban csak 1-2% „jön ki”.

Van-e mód arra, hogy az OKM adatai alapján mondjunk bármi érdemlegeset a hazai csalásokról? Készül egy alaposabb kutatás is, azonban ebben az írásban egyetlen jól megragadható jelentkezését szeretném kiemelni a csalásoknak. Amit bemutatok, az egyrészt a csalás felfedezésének egy különösen megbízható módját mutatja be, és olyan iskolák körében mutatok be adatokat, amelyek az OKM-eredmények alapján kimagaslóknak vannak elkönyvelve.

Egy rendkívül fontos erkölcsi, sőt, bizonyos értelemben jogi kérdést érdemes tisztázni a legelején. Az itt is bemutatandó módszer segítségével egyetlenegy iskoláról sem jelenthető ki 100%-os biztonsággal, hogy ott csalás történt. Csak gyanút fogalmazhatok meg, és valószínű, hogy az általam gyanúsnak vélt iskolák között van olyan, amelyben nem történt csalás, és a kimaradt iskolák között lehetnek olyanok, amelyekben viszont volt csalás, de annak mértéke nem érte el azt a küszöböt, ami lehetővé tette volna, hogy a „listámba” bekerüljenek ezek az intézmények. Ennek a bizonytalanságnak az az alapvető oka, hogy mindenfajta folytonos változók értékének becslésére használt tesztelésnek nagy az objektív, nem kiküszöbölhető hibája. Csak képzeljük el: egy iskola olyan eredményeket mutat az OKM-en, amelyek alapján gyanússá válik, de mégsem történt semmi szabálytalan, pusztán arról van szó, hogy egy rendkívül kis valószínűségű esemény következett be. Valami, de nem csalás, azt okozta, hogy az iskola 8.-os eredményei sokkal jobbak lettek, mint amilyen a tesztet megíró gyerekek két évvel későbbi OKM eredményei (ez lesz majd a számítás lényege, ahogy mindjárt részletesen is bemutatom). Erkölcsi kérdésről van szó számomra, valamint az írást megjelentető kiadó számára, hiszen nem tehetjük meg, hogy nyíltan megvádolunk iskolákat, ha egyszer az egyetlen bizonyíték, ami rendelkezésre áll, nem kellően biztos. És nyilván jogi problémák is felvetődnének, bármelyik iskola, amely „vád alá kerülne”, törvény előtt kifogásolhatná az eljárásomat. Tanúkkal, dokumentumokkal nem tudnám bizonyítani az „igazamat”, pusztán bizonytalanságot hordozó számokkal. Éppen ezért ebben az írásban egyetlenegy iskola neve sem szerepel. Egy kis csűrés-csavarással talán megtehetném, hogy közreadom azon iskolák nevét, amelyek egy bizonyos küszöbértéket átléptek a számításaimban, nem állítva, hogy ezek biztosan csaltak, csak azt, hogy átlépték a küszöböt. Sok iskola még így is valószínűleg erősen tiltakozna a szerepeltetése ellen, hiszen azt állíthatnák, hogy közvetett módon mégiscsak alkalmas egy ilyen lista a megbélyegzésre. A tiltakozók között nagy valószínűséggel lennének csalók és nem csalók is.

De nézzük, hogyan lehet valószínűsíteni egy iskolával kapcsolatban, hogy ott csaltak az OKM során! Sok módja van ennek, abban a bizonyos gazdag nemzetközi szakirodalomban a metodikai részletek szerepelnek. Én most csak egyetlen módszert ismertetek. Úgy látom, hogy a hazai viszonyok között e módszer kiemelkedik a „biztonságát” tekintve. Ezt úgy értem, hogy az e módszerrel gyanúsnak talált iskolák esetében rendkívül nehéz más indokot mondani a furcsa eredményekkel kapcsolatban, lényegében csak a csalás jön számításba, kivéve azt, hogy igen kis valószínűséggel, de előfordulhat, hogy ez a bizonyos furcsa eredmény a véletlen műve.

A módszer valójában igencsak egyszerű. Csak 8. évfolyamon használható, és csak a legutóbbi ismertté vált OKM adatokhoz képest két évvel korábbi mérésre vonatkozhat. Az itt bemutatásra kerülő adatok esetén a 2015-ben 8. osztályos, OKM-teszteket író általános iskolások eredményei szerepelnek, figyelembe véve, hogy ezek a gyerekek mit produkáltak két év múlva, 2017-ben, 10. osztályban. Képzeljük el, hogy egy adott iskolában csalás történt 2015-ben, a 8.-osok matematika tesztje feladatainak megoldása során! Mivel általános iskoláról van szó (nem hat és nem nyolc évfolyamos gimnáziumról), ezért a tanulók még 2015-ben elkerülnek innen, valamely középfokú tanintézetben folytatják tanulmányaikat, és 2017-ben megírják a 10.-es OKM teszteket. Persze nem mindenkivel ez a helyzet. Nem vehetem számításba azokat, akik nem tanulnak tovább, akik továbbtanulnak, de a 2017. évi 10.-es OKM megírása előtt lemorzsolódnak, akik valamilyen más ok miatt nem írnak 2017-ben teszteket. Vagyis a számításaim egy-egy általános iskola 2015. évi 8. évfolyamán tanulók egy részhalmazára vonatkoznak. Akkor „furcsa” egy adott iskolában a számításba vehető 8.-osok eredménye, ha kiderül, hogy 10.-ben kapott tesztpontszámaik átlaga jóval kisebb, mint a 2015-ös 8.-os átlaguk. Ez teremti meg a gyanút a csalással kapcsolatban. 8.-ban irreálisan magas volt a számításba bevont gyerekek eredménye ahhoz képest, hogy aztán 10.-ben mit produkáltak.

Keressük a furcsa adatokat, de szükség van egy küszöbérték kijelölésére. Milyen különbség esetén tekintsük a két átlagpontszámot furcsának? A 2017. évi OKM-ben az akkor felmért összes tanulót véve a korábbi, 8.-os pontszámhoz viszonyított átlagos növekedés (ami számomra egyébként a pedagógiai hozzáadott érték, PHÉ) matematikából 21, szövegértésből 39 pont volt (egészre kerekítettem). Vagyis például matematikából átlagosan a tanulók 21 ponttal jobb eredményt értek el 10.-ben, mint 8.-ban. Persze, ez igen nagy szórással valósult meg. Matematikából ez a szórás 133, szövegértésből 125 pont. Vagyis nem is kis számban fordult elő, hogy a tanulónak 8.-hoz képest 10.-re csökkent a teszteredménye. Természetesen nem lett „butább”, csak az történt, hogy a nagy hibával bíró mérésben a tesztpontszámok éppen ilyenek lettek. A hibák tetemes volta nagyon óvatossá kell, hogy tegyen mindenkit, aki OKM adatokkal számol. Biztosabb következtetésekre juthatunk, ha nem egyes tanulókat, hanem nagyobb csoportokat vizsgálunk. A mi esetünkben is erről van szó, hiszen egy-egy iskolában, 8. évfolyamon tanulók átlagadatait vesszük figyelembe. Minél nagyobb egy csoport, az átlagadatok hibája annál kisebb lesz. Ha a tanulók esetén a szórás 132 pont, akkor egy 9 fős csoport átlagának szórása már csak 44 pont, egy 16 fős csoporté 33 pont, egy 25 fős csoporté 26 pont (mint látható, a létszám négyzetgyökével, vagyis 3-mal, 4-gyel és 5-tel osztottam a csoportra jellemző szórást). A vizsgálatban az elemzett csoportok létszáma csak nagyon kevés esetben volt 9-nél kisebb. Egy fiktív példával igyekszem érzékeltetni a viszonyokat. Tegyük fel, hogy egy iskolában (FEH-en) 2015-ben 9 olyan 8.-os tanuló volt, akinek akkor is, és 2017-ben is voltak teszteredményei. Tegyük fel, hogy a két teszteredmény különbségét képezve a 9 tanulónál az eredmények (konkrét értékük most nem érdekes) szórása 132 pont lett. Milyen értékeket kapnánk a 9 tanulóra vonatkozó különbségek átlagára, ha módunkban állna ezután még többször is elvégezni a tesztelést? (Ez nyilván gondolatkísérlet, valóságosan nem, hogy többször, de még csak egyszer sem ismételhetnénk.) Minden tesztelés esetén más és más eredmény jönne ki, de a statisztikai törvényszerűségek azt diktálják, hogy ezeknek az eredményeknek a szórása kb. 44 pont lenne, mert a csoportba tartozók eredményeinek szórását el kell osztani a csoport létszámának négyzetgyökével, jelen esetben 3-mal. Mit is jelent ez a csoportra vonatkozó mérési hibával kapcsolatban? Ha mondjuk ez egy „nagyon átlagos” csoport lenne, vagyis a nem ismert, látens képességfejlettség növekedésük átlaga mondjuk 30 pont lenne, akkor 95%-os valószínűséggel esne a mért tesztpontszám különbségeik átlaga a (30 – 2×44; 30 + 2×44), vagyis a (–58; 118) intervallumba. (Egy viszonylag egyszerű, bár nyilván sokak által nem ismert összefüggés miatt van így, kérem, hogy az olvasó, ha nem ismeri az összefüggést, most fogadja el, hogy ez egy megalapozott állítás.) Ennek alapján akkor tekintem csalás szempontjából gyanúsnak egy általános iskola eredményeit, ha az e számításban figyelembe vehető tanulóinak 2015 és 2017 között, a 8.-os és a 10.-es mérést tekintve átlagosan legalább 100 ponttal csökkent az eredményük. Mint láttuk, egy példa jellegű számítás azt mutatta, hogy ez a –100 pont „bőven kívül van” azon a tartományon, amelyben az esetek kb. 95%-ában meg kellene jelennie a különbségátlagnak. Ha nagyobb csoportról van szó, akkor az eredmény még „élesebb”, vagyis erősebb lehet a csalás gyanúja. (A számítást másképpen is végezhetnénk, minden csoport esetén tudnánk jobb becsléseket is adni a pontszámváltozás hibájára, azonban a bemutatott példa azt jelzi, hogy a 100 pontos csökkenésnél is nagyobbat produkálni már csak rendkívül kevés esetben lehet a véletlen eredményeként, ha egy iskola esetében ez a csökkenés 100 pontnál nagyobb, az nagyon erős gyanút jelent a csalásra vonatkozóan.)

Azt vizsgáltam tehát, hogy mely iskolák (mely FEH-ek) azok, amelyekben a számításba vehető 8.-os tanulók 2015-ben magas tesztpontszám átlagot produkáltak, majd két év múlva, 10. osztályban hirtelen, mondhatni érthetetlenül nagyon alacsonyat, jelesül: legalább 100 ponttal kisebbet. Nem iskolákat, hanem FEH-eket, vagyis feladatellátási helyeket vizsgáltam. Egy FEH nagyon sok esetben azonos valójában egy általános iskolával, csak azokban az esetekben nem igaz ez, amikor több eredetileg általános iskolaként működő intézmény került egyetlen iskolai irányítás alá, vagy valami más okból van több önálló általános iskolai „részlege” az intézménynek. Vagyis néhány általános iskola több FEH-et tartalmaz, leggyakrabban ez azt jelenti, hogy földrajzilag egymáshoz közeli telephelyeken működő általános iskolai egységekről van szó.

2015-ben az OKM-ben 2781 általános iskolában volt 8. évfolyamon kompetenciamérés. Ezek közül a fenti értelemben a matematika tesztet tekintve gyanúsnak minősül 228, vagyis 8,2%. Az általam alkotott kritérium azonban a 9 fős létszám alatt már fokozatosan elveszíti az erejét, a fenti számítás azt jelezte, hogy a 9 fő esetén még igen erős. A 228 elsőre gyanúsnak minősített FEH-ek közül csak 144-ben volt 9 fő, vagy annál nagyobb a figyelembe vehető tanulók létszáma, illetve az egész évfolyamon az ilyen FEH-ek száma 2364 volt. Az arány így 6,1%, ami némileg magasabb, mint az Egyesült Államokban lezajlott vizsgálatokban felső határként szereplő 5%.

A szövegértés esetében 50 olyan FEH volt 2015-ben, ahol gyanús, hogy csaltak, illetve a figyelembe vehető tanulók létszáma legalább 9 volt. A gyanús FEH-ek számaránya az összes figyelembe vehetőhöz (2364) képest így 2,1%. Nyilván nem kell örülni egyetlen csalásnak sem, de ez az arány viszonylag kicsinek mondható. Úgy tűnik, hogy matematikából sokkal jelentősebb probléma a csalás.

Megnézhetjük azt is, hogy hány FEH-en volt érvényes az, hogy vagy matematikából, vagy szövegértésből, vagy akár mindkettőből gyanús az eredmény (és persze legalább 9 fő a figyelembe vehető tanulók létszáma). 168 ilyen FEH-et találtam, a 2364 FEH-nek ez a 7,1%-a. Hasonlóan a matematikára kapott értékhez, ezt is nagyon figyelmeztetőnek kell tekintenünk szerintem. 144 FEH-en matematikából, 50 FEH-en szövegértésből lehetett csalás, legalább az egyik pedig 168 helyen volt, ez azt jelenti, hogy 144 + 50 – 168 = 26 FEH mindkét tesztet tekintve gyanús.

Példákkal (az iskolák megnevezése nélkül) érzékeltetem, hogy milyen jellegűek az eredmények. Egy FEH-en, amely azonos egy iskolával, 16 tanuló írt 8.-os matematikát 2015-ben és 10.-es matematikát 2017-ben. 2015-ben az átlagpontszámuk 1772 pont volt, 2017-ben 1513. Vagyis a két időpont között e gyerekek tesztteljesítménye az átlagot tekintve 259 ponttal lett rosszabb. Természetesen nem azonos a lehetetlen eseménnyel, hogy ez véletlenül, a sztochasztikus természetű tesztelési hibák miatt következzék be, de ennek szinte elhanyagolhatóan kicsi a valószínűsége. Igencsak erős lehet a gyanúnk, hogy ebben az iskolában csalás történt a matematika tesztek megírása során 2015-ben, a 8. évfolyamon. Ugyanebben az iskolában szövegértésből 2015-ben 1534 pontos átlagot produkáltak a számításban figyelembe vett gyerekek, míg 2017-ben 1505 pontot. Itt is csökkenés van, de ennek mértéke csak 29 pont, ezért ez az iskola nem is szerepel a másik „listában”, amelyben a szövegértés tekintetében gyanús FEH-ek találhatók. Nem így az a FEH, amelyen szintén 16 tanuló adatait vehettem figyelembe. Matematikából 172 ponttal csökkent az átlaguk, szövegértésből pedig 147 ponttal. Vagyis ez a FEH mindkét tesztet tekintve gyanússá vált.

Azokon a FEH-eken, ahol legalább 9 fő a figyelembe vehető tanulók létszáma matematikából a leginkább kirívó eredményt egy 20 fős csoport produkálta: 398 ponttal lett kisebb a 2017-es átlaguk, mint a 2015-ös volt. Érdekes módon szövegértésből nagy valószínűséggel itt nem történt csalás, mert a 20 tanuló pontszámváltozása pozitív lett, 16 pont.

Szövegértésből a legnagyobb különbséget egy a figyelembe vehető tanulókat tekintve 10 fős létszámmal rendelkező FEH érte el, a pontszámváltozások átlaga –299 pont. Ezen a FEH-en matematikából –356 pont volt a pontszámkülönbségek átlaga, vagyis mindkét teszt esetében gyanúsnak minősül a FEH.

Ezeknek az adatoknak a bemutatása miatt azonban ezt a tanulmányt nem írtam volna meg, hiszen egyrészt van az itt alkalmazottnál jobb eljárás is a csaló iskolák kiszűrésére, másrészt a kutatás igazából most kezdődne, hiszen rendkívül érdekes lenne megvizsgálni, hogy a gyanúra okot adó FEH-eket mi jellemzi, hol helyezkednek el elsősorban területileg, milyen fenntartókhoz tartoznak, inkább a jobb vagy a rosszabb teljesítményű iskolák a gyanúsak, vagy nincs ilyen összefüggés, stb. Amiért már ennek az egyelőre szinte csak tájékozódó jellegű elemzésnek az eredményeit közreadom, az egy érdekes fejlemény. Az Oktatási Hivatal (OH) közzétette az úgynevezett kiemelkedő iskolák listáját. Pontosabban többféle lista van. Kétféle módszert alkalmaztak a kollégák. Az egyik esetben azt nézték meg, hogy egy iskolában a tanulók előző tesztelésen elért eredményeihez képest milyen eredmények születtek, és ha ezekhez viszonyítva az iskola szignifikánsan jobb eredményt ért el, mint az országos átlag, akkor bekerült a kiemelkedők listájába. A másik módszer viszont az átlagos szociális helyzetet vette figyelembe, kiszámítva, hogy milyen eredményt várnánk az iskolától az ott a tesztet megíró gyerekek átlagos családiháttér-indexe alapján. Azok az iskolák kerültek be a kiválóak közé, amelyek e tekintetben teljesítettek az elvártnál szignifikánsan jobban. E listákat kialakították az OH szakemberei 2015-re, 2016-ra és 2017-re is, az első szempont szerint a 8. és a 10. évfolyamokra, a második szempont szerint a 6., 8., 10. évfolyamokra, és minden változat esetén készült egy lista matematikából és egy szövegértésből. (Az információk az OH honlapján érhetők el.)

Itt vannak tehát előttünk az elmúlt három tanévben különböző szempontok alapján kiemelkedőnek bizonyult iskolák listái. Az jutott eszembe, hogy vajon ezek között milyen arányban fordulhatnak elő olyanok, amelyeken – valamelyik FEH-ükön, ha több is van az intézményben – erősen gyanítható, hogy volt csalás. A vizsgálat nem teljes, csak az első módszerrel meghatározott listákat vettem figyelembe, csak a 8. évfolyamokra, és csak a 2015. évre vonatkozókat.

Nézzük először az átfogó adatokat, természetesen továbbra sem megnevezve egyetlen iskolát sem. A megbízhatóság növelése érdekében továbbra is csak azokat a FEH-eket veszem figyelembe, amelyeken a számítások során felhasználható adatok száma elérte a 9-et (legalább 9 tanuló volt figyelembe vehető a FEH-en). Ilyen FEH összesen 2364 volt.

Matematikából 297 FEH iskolái kerültek a kiemelkedők listájába. Mivel egy iskola több FEH-et is tartalmazhat, ezért az eredeti OH listában, amelyben nem FEH-ek, hanem iskolák szerepelnek, kisebb az adatsorok száma: 247 iskoláról van szó. Mivel én a gyanús esetek meghatározásában a FEH adatokat vettem figyelembe, így az arányok kiszámításánál a 297-es számot használom. A 297 FEH, melyeknek iskolája matematikából kiemelkedőnek bizonyult az OH számításai szerint, a 2364 FEH-nek a 12,6%-a. A 297 FEH-ből viszont 53 minősült matematikából gyanúsnak, arányuk a kiemelkedettek számához viszonyítva 17,8%. Ezt a számarányt azzal érdemes összehasonlítani, hogy az összes FEH 6,1%-a volt gyanús. A sokkal nagyobb arány részben érthető, hiszen ha egy iskolában jelentős hatású volt a csalás, akkor az iskola könnyen kerülhetett – érdemtelenül persze – a kiemelkedők közé.

De nézzük, mi a helyzet szövegértésből! Az OH 2015-ben, a 8. évfolyamot tekintve az első módszer szerint szövegértésből 126 iskolát minősített kiemelkedőnek, ez az én számításaim során 182 FEH-et jelent, ami az összes, 2364 FEH 7,0%-a. E 182 FEH közül a leírt számítások elvégzése után 19 lett gyanús, az arány a kiemelkedők számához képest 10,4%. Ez is jóval nagyobb arány, mint a csalással gyanúsítható FEH-ek számának az összes FEH számához viszonyított 2,1%-os aránya.

Vegyük figyelembe egyszerre a két tesztet! Az OH matematikából vagy szövegértésből (legalább az egyikből) kiemelkedőnek minősített iskolákat, az ezekben működő, legalább 9 a számításoknál figyelembe vehető tanulóval rendelkező FEH-ek száma 403. Ezek között gyanúsnak bizonyult vagy a matematika vagy a szövegértés (vagy mindkettő) tesztben nyújtott teljesítménye alapján 67. Az arány 16,6%. Látjuk, hogy ez az arányszám is jóval nagyobb, mint a teljes évfolyamon a csalással gyanúsíthatók 7,1%-os aránya.

Hozzá kell tennem ezekhez az adatokhoz, hogy a csalás kérdését itt csak intézményi szinten vetettem fel. Félő, hogy ha az osztályok szintjén vizsgálódnánk, rosszabb eredményeket kapnánk. Módszertanilag azonban az osztályszintű vizsgálódás megbízhatósága lényegesen kisebb az intézményi szintéhez viszonyítva, mert az osztálylétszámok még kisebbek, ezért nagyon nagy lenne az elemzésből kizárt csoportok száma. Persze az is igaz, hogy ha rendelkezésünkre állnak majd a 2018., 2019. évi kompetenciamérési adatok is, akkor újra számolva mindent, bevonva a vizsgálódásba azokat a tanulókat is, akik 2018-ban, 2019-ben írtak, írnak teszteket, javítható lenne a megbízhatóság. Csak az a baj, hogy ahogy haladunk előre az időben, úgy csökken a 2015. évi helyzet elemzésének jelentősége.

Talán nem is nagyon kellene kommentálni ezeket az eredményeket. Szövegértésből kisebb mértékű, matematikából azonban jelentősebb hatású a csalás. A csalás hatása azon is lemérhető, hogy elég sok iskola kerül be kiemelkedőknek minősítettek közé úgy, hogy erős lehet a gyanúnk, hogy azokban az iskolákban csaltak a kompetenciamérésen. A „kiemelkedő” iskolák hatoda ilyen.

Felmerül több kérdés is az adatokat megismerve. Előre kívánkozik az, amit erkölcsi problémának mondhatunk. Maliciózusan kijelenthetjük, hogy itt tartunk. Sajnálkozhatunk. Ostorozhatjuk az iskolát, a pedagógusokat, vagy akár az oktatáspolitikát is, amely ezt az egészet nem tekinti problémának, és ezért nem is foglalkozik a megoldásával. A leginkább elszomorító az, amit ezek az adatok a magyar pedagógia állapotáról elárulnak.

Az a kérdés is felmerül, hogy van-e értelme egyáltalán közzé tenni a kiemelkedőnek minősített iskolák listáit ilyen körülmények között. Az OH lépését első megközelítésben nagyon jónak találtam: ahelyett, hogy gyártanánk az iskolasorrendeket mindenféle, a szociális helyzettel erősen összefüggő mutatók alapján, koncentráljunk a pedagógiai hozzáadott értékre, és ne is adjunk meg sorrendet, csak azon iskolák listáját, amelyek kiemelkedőknek bizonyulnak. Ha nem lennének csalások, ez az eljárás szerintem tökéletes lenne. Az, hogy a listákban szereplő iskoláknak a hatoda esetén felmerül a csalás gyanúja, teljes mértékben diszkreditálja ezt a tényleg jobb sorsra érdemes kezdeményezést.

Természetesen felmerülnek kérdések az oktatáskutatás számára, fentebb ezeket már jeleztem. A csalás az oktatási rendszer egy jelensége, látjuk, hogy jelentős mértékben befolyásolja az iskolák megítélését, vagyis egy fontos tényezőről van szó, amely érdemes arra, hogy tudományos vizsgálat tárgya legyen.

Felmerülnek jogi és oktatásigazgatási kérdések is. Nem vagyok jogász, nem tudom megmondani, hogy a kompetenciamérések során történő csalás jogi értelemben minek minősül. Ha van ilyen jogi tényállás, akkor számolni kell azzal, hogy törvénybe ütköző cselekedet alapos gyanúja merülhet fel, vagyis minimum az igaz, hogy az oktatásigazgatás szerveinek eljárásokat kell indítaniuk. Ha nincs ilyen büntetőjogi tényállás, akkor felmerülhet, hogy legyen. Az biztos, hogy az e téren kialakult helyzet valamilyen jogi, igazgatási lépéseket is igényel.

Az oktatáskutató pedig szomorú, mert az amúgy rendkívül nagy értékkel rendelkező kompetenciamérési adatok „elszennyeződnek”, bizonytalanokká válnak, bizonytalanná téve ezzel a belőlük levonható következtetéseket is.

A szövegben jelzett szakirodalmi források

Cullen, J. és Reback, R. 2002. Tinkering Toward Accolades: School Gaming under a Performance Accountability System. Working paper. National Bureau of Economic Research, Cambridge, MA.

Jacob, B.A. és Levitt, S.D. 2002. Rotten Apples: An Investigation of the Prevalence and Predictors of Teacher Cheating. Working Paper 9413. National Bureau of Economic Research, Cambridge, MA.

Nichols, S.L. és Berliner, D.C. 2007. Collateral Damage: How High-Stakes Testing Corrupts America’s Schools. Harvard Education Press, Cambridge, MA. (Google könyv)